什么是Spark实时计算

随着大数据时代的到来,实时数据处理的需求日益增长。Spark实时计算作为一种高性能、可扩展的大数据处理技术,已经成为业界的热门选择。Spark实时计算是基于Apache Spark框架的一种数据处理方式,它能够对实时数据进行流式处理,实现对数据的快速响应和实时分析。

Spark实时计算的原理

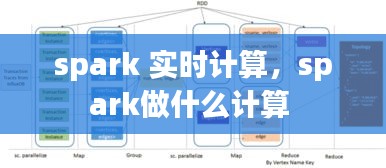

Spark实时计算的核心原理是利用Spark框架的弹性分布式数据集(RDD)和Spark Streaming模块。RDD是一种不可变的、可并行操作的分布式数据集,它可以在集群上高效地进行数据转换和聚合操作。Spark Streaming则是Spark框架的一个模块,专门用于处理实时数据流。

在Spark实时计算中,数据首先被采集并转换为Spark RDD,然后通过Spark Streaming进行处理。Spark Streaming提供了多种数据源,如Kafka、Flume、Twitter等,可以方便地从各种实时数据源中获取数据。处理过程中,Spark Streaming会对数据进行实时转换、过滤、聚合等操作,并将处理结果输出到目标存储或进行实时分析。

Spark实时计算的优势

Spark实时计算具有以下优势:

高吞吐量:Spark实时计算能够处理大规模的数据流,具有高吞吐量,能够满足实时数据处理的需求。

低延迟:Spark实时计算具有低延迟的特点,能够快速响应实时数据变化,提供实时分析结果。

可扩展性:Spark实时计算能够无缝扩展到大规模集群,满足不断增长的数据处理需求。

易用性:Spark实时计算提供了丰富的API和工具,易于开发和部署。

与其他Spark组件的兼容性:Spark实时计算可以与其他Spark组件,如Spark SQL、MLlib等无缝集成,提供全面的数据处理解决方案。

Spark实时计算的应用场景

Spark实时计算在各个领域都有广泛的应用,以下是一些典型的应用场景:

金融行业:实时监控交易数据,及时发现异常交易,防范金融风险。

电子商务:实时分析用户行为,优化推荐系统,提高用户体验。

社交媒体:实时分析用户动态,监控热点事件,提供精准广告。

物联网:实时处理传感器数据,优化设备管理,提高能源效率。

智慧城市:实时分析交通流量,优化交通管理,提高城市运行效率。

Spark实时计算的挑战与解决方案

尽管Spark实时计算具有许多优势,但在实际应用中仍面临一些挑战,以下是一些常见的挑战及相应的解决方案:

数据源多样性:Spark实时计算需要支持多种数据源,可以通过集成多种数据源驱动程序和适配器来解决。

数据质量:实时数据可能存在噪声和错误,可以通过数据清洗和预处理技术来提高数据质量。

资源管理:Spark实时计算需要合理分配集群资源,可以通过Spark的YARN或Mesos等资源管理器来实现。

安全性:实时数据处理需要确保数据安全,可以通过加密、访问控制等技术来提高安全性。

总结

Spark实时计算作为一种高效、可扩展的大数据处理技术,在实时数据处理领域具有广泛的应用前景。随着技术的不断发展和完善,Spark实时计算将为更多行业带来创新和变革。未来,Spark实时计算将继续优化性能,提高易用性,为用户提供更加便捷的实时数据处理解决方案。

转载请注明来自昌宝联护栏,本文标题:《spark 实时计算,spark做什么计算 》

冀ICP备19033229号-1

冀ICP备19033229号-1