引言

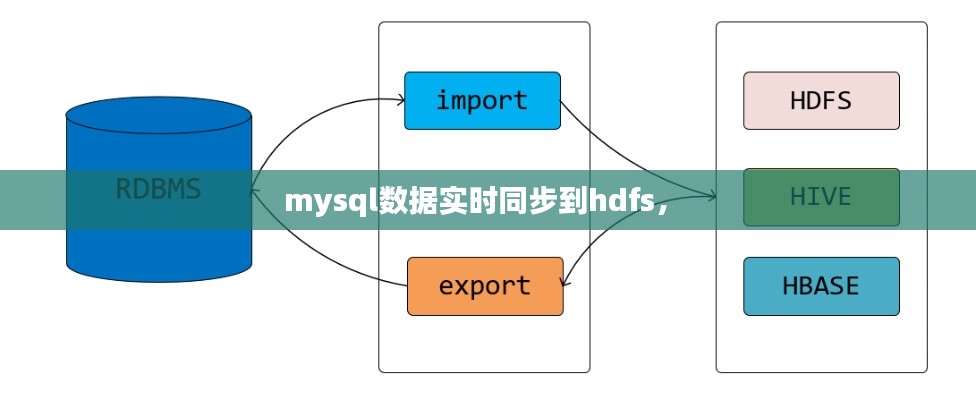

随着大数据技术的快速发展,数据存储和分析的需求日益增长。MySQL作为一款广泛使用的关系型数据库,其数据的安全性和可靠性至关重要。然而,在数据分析和处理过程中,往往需要将MySQL中的数据实时同步到Hadoop分布式文件系统(HDFS)中,以便进行大规模的数据处理和分析。本文将介绍如何实现MySQL数据实时同步到HDFS的过程。

MySQL数据同步到HDFS的背景

MySQL数据库广泛应用于各种业务系统中,存储着大量的业务数据。然而,MySQL数据库本身并不支持大规模的数据处理和分析。而Hadoop分布式文件系统(HDFS)作为Hadoop生态系统中的核心组件,具备高可靠性、高扩展性和高吞吐量等特点,非常适合存储和处理大规模数据。因此,将MySQL数据同步到HDFS,可以实现数据的分布式存储和高效处理。

数据同步工具介绍

为了实现MySQL数据实时同步到HDFS,我们可以使用以下几种工具:

- MySQL binlog:MySQL的二进制日志(binlog)记录了所有对数据库的更改操作,包括插入、更新和删除等。通过解析binlog,可以实现数据的实时同步。

- Canal:Canal是一个基于MySQL binlog的增量数据采集工具,可以将MySQL数据库的增量数据实时同步到其他存储系统中,如Kafka、Kafka Connect、Redis等。

- Flume:Flume是一个分布式、可靠、可用的数据收集系统,可以将数据从各种数据源(如MySQL、Kafka等)实时传输到HDFS中。

实现步骤

以下是实现MySQL数据实时同步到HDFS的步骤:

- 配置MySQL binlog:在MySQL数据库中配置binlog,并设置binlog的格式为“ROW”格式,以便记录每条记录的详细信息。

- 安装Canal:在服务器上安装Canal,并配置Canal的MySQL源和目标存储系统(如Kafka)。

- 配置Flume:在服务器上安装Flume,并配置Flume的数据源(如Kafka)和目标存储系统(如HDFS)。

- 启动Canal和Flume:启动Canal和Flume,Canal将实时采集MySQL的增量数据并推送到Kafka,Flume将Kafka中的数据实时传输到HDFS。

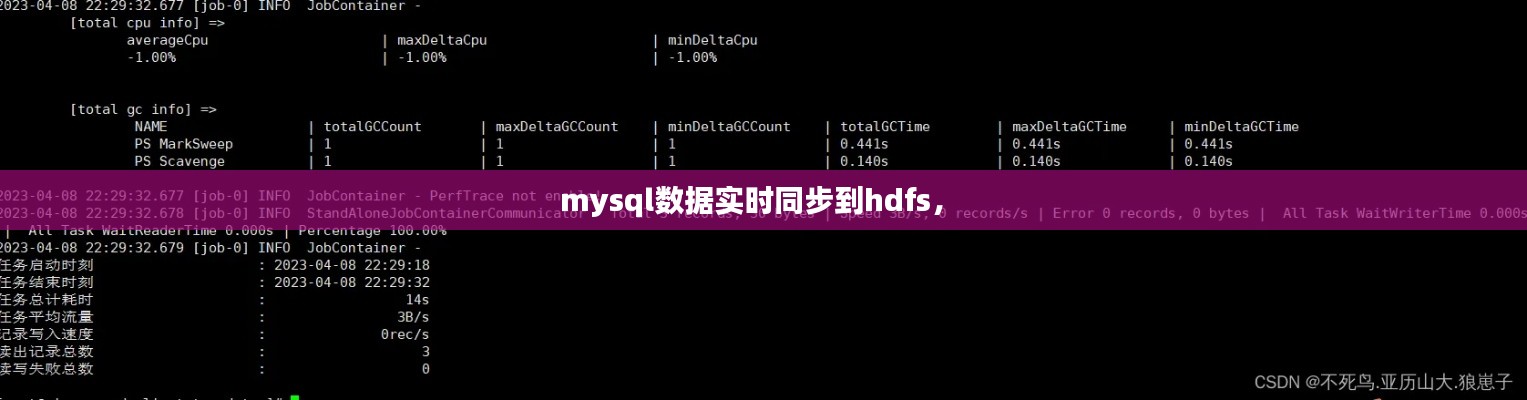

- 验证数据同步:通过查看HDFS中的数据,验证MySQL数据是否已成功同步到HDFS。

注意事项

在实现MySQL数据实时同步到HDFS的过程中,需要注意以下几点:

- 性能优化:根据实际需求,对Canal和Flume进行性能优化,以提高数据同步的效率。

- 数据一致性:确保MySQL和HDFS中的数据一致性,避免数据丢失或重复。

- 故障处理:在数据同步过程中,可能会遇到各种故障,如网络故障、服务器故障等,需要制定相应的故障处理策略。

总结

MySQL数据实时同步到HDFS是一个复杂的过程,需要综合考虑数据安全性、可靠性、性能等因素。通过使用Canal和Flume等工具,可以实现MySQL数据的高效、可靠同步到HDFS。在实际应用中,应根据具体需求进行配置和优化,以确保数据同步的稳定性和高效性。

转载请注明来自昌宝联护栏,本文标题:《mysql数据实时同步到hdfs, 》

百度分享代码,如果开启HTTPS请参考李洋个人博客

冀ICP备19033229号-1

冀ICP备19033229号-1